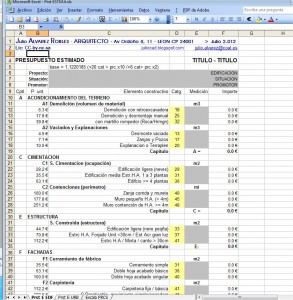

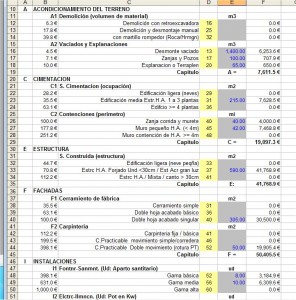

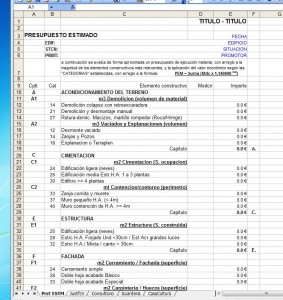

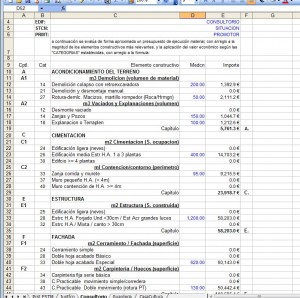

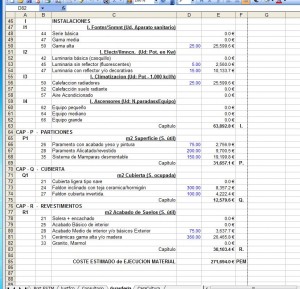

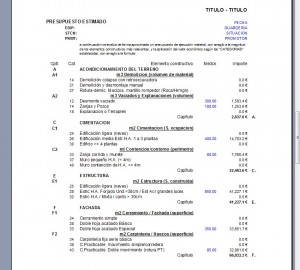

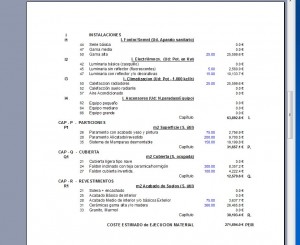

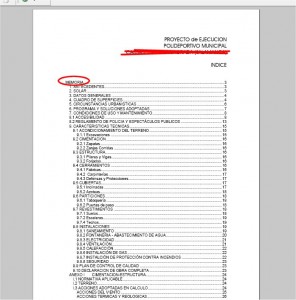

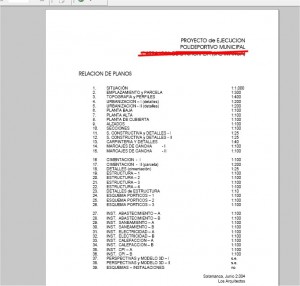

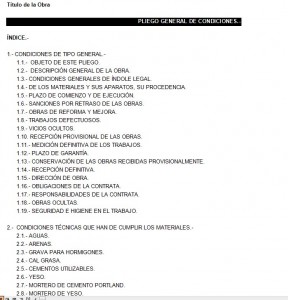

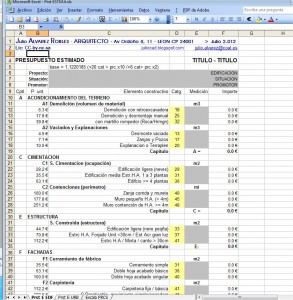

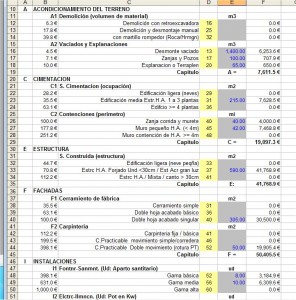

En la última entrada, se había formulado un sistema novedoso para elaborar “avances” de presupuestos de edificación, mediante un formulario incluido en una hoja de cálculo que se adjuntaba, basada en una escala de precios de tipo “logarítmico”, y una lista de elementos o componentes del edificio según la estructura de las “Normas Tecnológicas de Edificación” (NTEs).

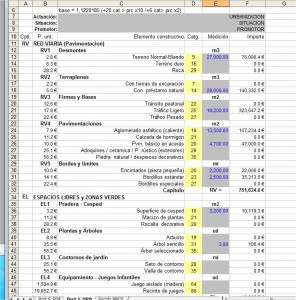

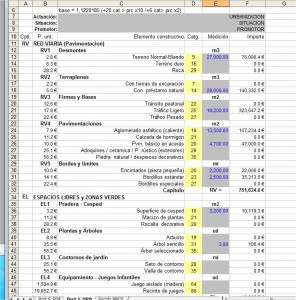

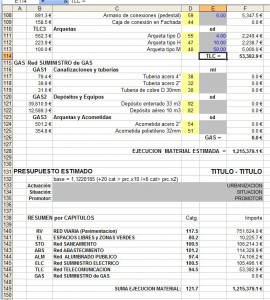

Considerando que a primera vista esa hoja de cálculo así como el método propuesto puede resultar algo confuso y extraño, se ha optado por tratar de desarrollar algo más la explicación de su funcionamiento y utilización, así como el interés para desarrollar una variante, adaptada a la obra civil que pueda servir para estimar un avance sobre los costes de un proyecto de urbanización.

Probablemente la consideración que puede resultar más extraña en esta propuesta, es el hecho de adoptar una “escala logarítmica” en sustitución del sistema de precios normal.

El valor de los precios.

En este sentido, hay que tener en cuenta que la idea o el concepto del “precio de las cosas”, resulta tan básica y elemental, que se encuentra automatizada por nuestra inteligencia, mediante mecanismos de comparación intuitivos, que permite valorar el precio de cada cosa comparando el valor del número que lo representa, con el de cosas similares o equivalentes ya conocidas, o que consultamos oportunamente.

De esta forma es prácticamente automático decidir la opción más barata o ventajosa, simplemente identificando aquel número que es mayor o menor, y también permite apreciar de una forma rápida e intuitiva cuánto y cuando se aleja un precio de un conjunto de valores similares o parecidos.

No obstante si analizamos esos mecanismos con algo de detenimiento, es fácil entender que están vinculados con las operaciones aritméticas de carácter elemental como la “comparación” o las “sumas y restas”, aunque si bien para realizar las operaciones aritméticas siempre es necesario manejar el valor numérico completo de cada precio, presumiblemente los mecanismos intelectuales operan de forma diferente, ya que normalmente tardamos en “retener” con la memoria el valor completo de cada precio, pero recordamos con cierta facilidad cual era el “mayor/menor”, o bien una aproximación relativa en una secuencia “grande/pequeño”.

Probablemente esos mecanismos intelectuales son los mismos que operan cuando los comerciantes promocionan sus ofertas con precios que se quedan ligeramente antes de incrementar una nueva cifra en el valor del precio (..99, ..95, ..990, … ) ya que recordamos más fácilmente si un precio se encuentra por debajo o por encima del “límite virtual” constituido por el valor redondo o salto de cifras: decenas, centenas, miles, etc.

Todo el mundo tiene perfectamente claro el mecanismo del “regateo”, consistente en alcanzar un acuerdo entre dos partes, vendedor y comprador, en la que se intercambia algún objeto o mercancía por dinero, siendo el propio “acuerdo” el que establece la cantidad de dinero que se intercambia, y constituye obviamente el “precio” efectivo y real de la misma.

Todo el mundo tiene perfectamente claro el mecanismo del “regateo”, consistente en alcanzar un acuerdo entre dos partes, vendedor y comprador, en la que se intercambia algún objeto o mercancía por dinero, siendo el propio “acuerdo” el que establece la cantidad de dinero que se intercambia, y constituye obviamente el “precio” efectivo y real de la misma.

Lógicamente dentro del regateo, los “precios iniciales” como valor numérico, no tienen la menor importancia, siendo mucho más decisiva la capacidad para ir acercando esos valores o posiciones mediante una “modificación”, que puede ser más o menos rápida o hábil, pero que en ultima instancia solo depende de la voluntad y el interés de cada una de las partes por llegar al acuerdo.

Como resumen podemos decir que en el regateo, es la capacidad de aproximación al punto de equilibrio, tratando de discernir el “interés y capacidad” de la otra parte, en función de los “tanteos” y “aproximaciones” que se realizan. Obviamente esa aproximación se hace mediante unos valores numéricos, cuya cuantía es intrascendente en sí misma, pero que tienen un cierto valor como “indicio” del posible acercamiento, o punto de partida para la aproximación y el ajuste.

Teniendo en cuenta las consideraciones anteriores, parece lógico pensar que la gran cantidad de datos numéricos que se incluyen en el presupuesto de un proyecto, si bien es imprescindible como registro y respaldo de las condiciones del contrato de obra, sin embargo en otras circunstancias, acarrea un exceso de valores numéricos, que en cierta medida dificulta el tipo de pequeños tanteos y aproximaciones propias del “regateo”, que desarmarían un conjunto, que cuando pierde su propia coherencia interna, se desmorona como un castillo de naipes.

La regla de cálculo y los logaritmos

Aquellos que hemos llegado a conocer y manejar la “regla de cálculo”, cuando aún no se usaban las calculadoras electrónicas, disponemos de una mayor facilidad para valorar la utilidad práctica de los “logaritmos”. Sin embargo para las generaciones actuales, oír hablar de ellos suena más bien a “cosas de gente rara”, o a lo sumo a una tecla que se encuentra disponible en algunas calculadoras.

El concepto de “logaritmo” se explica en matemáticas o bien en la Wikipedia, y es introducido en el siglo XVII por Napier. Seguramente la propiedad más característica es el hecho de que el logaritmo de un “producto” de dos números, es igual a la “suma” de sus logaritmos. Esa propiedad es la que se usa en las reglas de cálculo, para disponer un par de escalas iguales, que pueden deslizarse entre sí, y que se gradúan de tal forma que la posición o longitud de cada número es proporcional a su logaritmo. De esta forma cuando queremos multiplicar dos números, solo tenemos que situar el origen de la escala deslizante en la posición del primer número, y a continuación leyendo el segundo número sobre la que ya hemos deslizado, tenemos alineado con este, el numero que representa la suma de longitudes de ambos segmentos y que por tanto es el “producto” de los dos números.

El concepto de “logaritmo” se explica en matemáticas o bien en la Wikipedia, y es introducido en el siglo XVII por Napier. Seguramente la propiedad más característica es el hecho de que el logaritmo de un “producto” de dos números, es igual a la “suma” de sus logaritmos. Esa propiedad es la que se usa en las reglas de cálculo, para disponer un par de escalas iguales, que pueden deslizarse entre sí, y que se gradúan de tal forma que la posición o longitud de cada número es proporcional a su logaritmo. De esta forma cuando queremos multiplicar dos números, solo tenemos que situar el origen de la escala deslizante en la posición del primer número, y a continuación leyendo el segundo número sobre la que ya hemos deslizado, tenemos alineado con este, el numero que representa la suma de longitudes de ambos segmentos y que por tanto es el “producto” de los dos números.

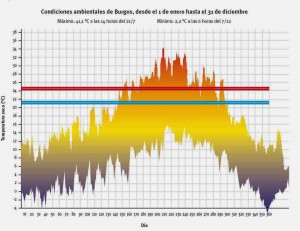

Otra de las utilidades destacable de los logaritmos, es la de representar con un conjunto de valores relativamente limitado, un repertorio de magnitudes y valores que pueden ser muy dispares entre sí como sucede en el caso del sonido. La escala que utilizamos normalmente para representar los niveles de ruido, se define en “decibelios” y varía entre 10 y 120. No obstante hay que pensar que lo que representan estos valores es en realidad el “tamaño” del número que corresponde a la “intensidad” del sonido medida en las unidades habituales de energía, o lo que es lo mismo un sonido de 20 decibelios tiene una energía que se representa con un número de dos cifras, y un sonido de 120 decibelios, necesitaría un número de doce cifras.

Obviamente si tenemos que hacer cálculos entre números de dos o tres cifras combinados con otros de más de diez, la propia “precisión” en la determinación de magnitudes, y el consecuente manejo de los errores de precisión, conduce a cálculos numéricos laboriosos con poco interés práctico. Eso se evita manejando los “logaritmos de la intensidad”, en lugar de los propios valores de la intensidad, con lo que se reduce considerablemente esa dispersión, aunque también a costa de que su “significado” pasa a ser relativamente opaco y poco intuitivo.

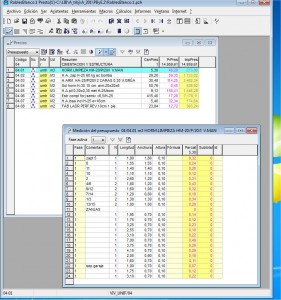

“El modelo en la Hoja de cálculo”

Un modelo de “avance”

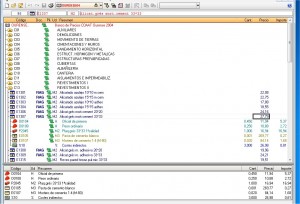

En el caso de los precios de un presupuesto se pueden encontrar ciertos paralelismos, si consideramos que una obra civil puede alcanzar los diez millones de euros (7 cifras) y sin embargo el precio de un metro cúbico en desmonte de tierra puede ser solamente de uno o dos euros (1 cifra). Por otra parte cuando modificamos ligeramente un determinado precio, como se hace en el regateo, estamos acostumbrados a pensar en términos de “porcentaje”, ya que de esta forma se valora mejor la cuantía relativa del cambio, ya que obviamente no es lo mismos rebajar un euro sobre una mercancía con un valor de diez que sobre otra de cien.

En el caso de los precios de un presupuesto se pueden encontrar ciertos paralelismos, si consideramos que una obra civil puede alcanzar los diez millones de euros (7 cifras) y sin embargo el precio de un metro cúbico en desmonte de tierra puede ser solamente de uno o dos euros (1 cifra). Por otra parte cuando modificamos ligeramente un determinado precio, como se hace en el regateo, estamos acostumbrados a pensar en términos de “porcentaje”, ya que de esta forma se valora mejor la cuantía relativa del cambio, ya que obviamente no es lo mismos rebajar un euro sobre una mercancía con un valor de diez que sobre otra de cien.

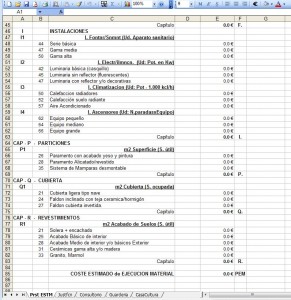

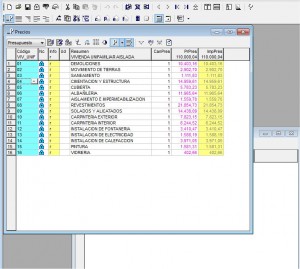

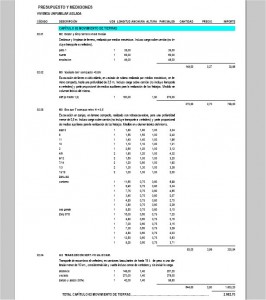

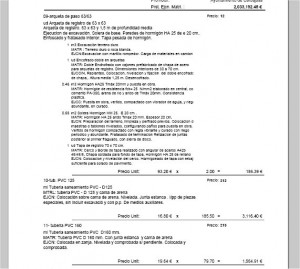

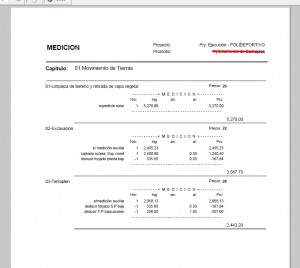

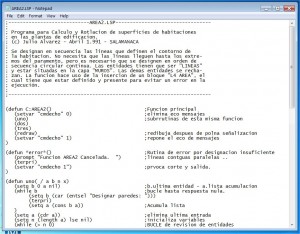

El modelo que se propone, trata de reducir la cantidad de datos que maneja, con el fin localizar más fácilmente la contribución de cada una de las partes en el resultado final. Eso nos lleva a establecer una lista cerrada, similar al resumen de capítulos, aunque subdividiendo cada uno en las partes más características, tratando de no sobrepasar los cuatro o seis en cada uno. Eso supone que los índices para valorar esos componentes deberán estar sobredimensionados en compensación con el resto de elementos que no son incluidos en la lista. Por otra parte la lista de capítulos se organiza sobre las partes o componentes físicos de la obra al estilo de las NTEs, en lugar de hacerlo sobre los “oficios” o tareas de la construcción.

En relación con los precios, naturalmente se descartan las exhaustivas descomposiciones de: materiales, mano de obra y maquinaria, pero además de eso se considera conveniente reducir en lo posible la dispersión de valores que suponen las cifras de los distintos precios, ya que cada cifra “concreta” no es demasiado importante en sí misma, y por otra parte también parece oportuno que pueda admitir una cierta variación porcentual sin ser relevante en el resultado.

Dentro de la lista cerrada, cada componente se caracteriza con una “magnitud” específica, (m3 / m2 / ml / ud ..) y a través de la medición correspondiente se cuantifica su intervención en el presupuesto. Las distintas alternativas dentro del mismo componente, pueden ser compatibles dentro un presupuesto, pero tampoco es necesario que estén todas presentes, lo cual se logra anotando o suprimiendo en la casilla de medición, el valor o cuantía oportuna.

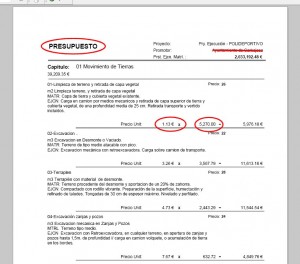

La especificación correspondiente al precio de cada componente, ya se encuentra incluido en la hoja de cálculo, por lo que al anotar la medición se presenta de manera inmediata el importe del apartado y el capítulo. En esta característica radica sobre todo la singularidad del sistema, ya que en lugar de emplear el precio correspondiente a ese componente concreto, se utiliza un sistema de índices o categorías, con un significado diferente.

La especificación correspondiente al precio de cada componente, ya se encuentra incluido en la hoja de cálculo, por lo que al anotar la medición se presenta de manera inmediata el importe del apartado y el capítulo. En esta característica radica sobre todo la singularidad del sistema, ya que en lugar de emplear el precio correspondiente a ese componente concreto, se utiliza un sistema de índices o categorías, con un significado diferente.

La categoría del precio se encuentra anotada en una columna a la izquierda de la medición. Está definida por un “número entero de dos cifras”, que a su vez contribuye a reducir notablemente la cantidad y dispersión de valores numéricos respecto a lo que se utiliza habitualmente. Este índice o categoría es el logaritmo del precio unitario correspondiente, definido sobre una “base” específica, con el valor: “1,1220185”, y redondeado al entero más cercano. Al utilizar logaritmos en sustitución del precio normal, el importe de la partida se calcula como el producto de la “medición”, por esa “base”, elevada a la “potencia” del número entero de la categoría.

Aunque inicialmente puede parecer bastante extraño el uso de “logaritmos”, en sustitución de los precios normales, realmente lo que se esta haciendo es “reducir” drásticamente el repertorio de valores que se emplean, sustituyendo el conjunto continuo de cifras que se encuentra entre 1€ y 89.125,5€ por el conjunto de números enteros de dos cifras que va desde “0” hasta “99”, ya que: 1,1220185 ^ 99 tiene precisamente un valor de 89.125,5€.

De esta forma solamente se emplean como “precios válidos” para cualquier componente, aquellos valores que coinciden con una “potencia” entera de la base establecida, y lógicamente se encuentran separados entre sí por una cuantía relativa respecto al anterior que siempre es el 12,20185%. Este mecanismo asegura precisamente que un incremento de una categoría en cualquier componente, siempre tiene una incidencia aproximada del doce por ciento sobre el valor resultante, con independencia de cuál fuera el valor inicial. Con el fin de facilitar el uso práctico de la hoja de cálculo, se incluye en el margen izquierdo la cifra en precio tradicional que corresponde a la categoría de cada componente.

La elección de la base, podría hacerse con cualquier otro número menos complicado como 1,10 – 1,15 ó 1,20, con lo que se obtendrían unos incrementos del 10%, el 15% ó el 20% en cada aumento de categoría, pero se ha preferido adoptar la “base”, de tal forma que un aumento de veinte (20) categorías, incrementa un orden de magnitud o multiplica por diez (x10) el valor inicial. Establecido este requisito, si hacemos un cálculo elemental con potencias, podemos ver que esa base tiene que ser la “raíz” veinteava de 10. Es decir “base” = 10 ^ (1/20) = 1,1220185. Con esta base, además de ese incremento singular, también se consigue que el aumento de “seis” categorías, duplique el precio inicial.

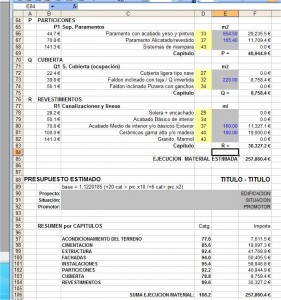

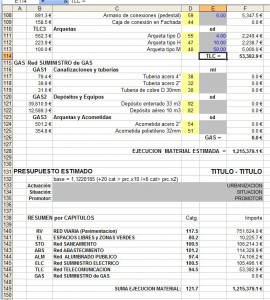

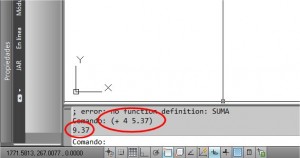

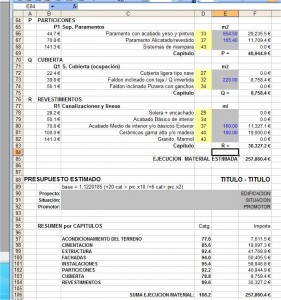

El empleo de la escala logarítmica en si mismo, NO limita el uso de números enteros, por lo que realmente la definición de categorías podría hacerse perfectamente con los números ampliados a una o varias cifras decimales, pero en ese caso el modelo perdería una parte significativa de su propia identidad, ya que uno de los objetivos, es la reducción drástica de datos numéricos al mínimo imprescindible, contribuyendo a que sea más fácil, tener una idea global del conjunto. No obstante en la hoja de calculo, se incluye al final de la misma un resumen por capítulos, en la que junto al importe de cada uno, se anota el valor de la “categoría” equivalente a ese importe, esta vez, redondeada con una cifra decimal. Este cálculo partiendo del importe responde obviamente a la expresión: “ cat = log(Importe) / log 1,1220185 ”

El empleo de la escala logarítmica en si mismo, NO limita el uso de números enteros, por lo que realmente la definición de categorías podría hacerse perfectamente con los números ampliados a una o varias cifras decimales, pero en ese caso el modelo perdería una parte significativa de su propia identidad, ya que uno de los objetivos, es la reducción drástica de datos numéricos al mínimo imprescindible, contribuyendo a que sea más fácil, tener una idea global del conjunto. No obstante en la hoja de calculo, se incluye al final de la misma un resumen por capítulos, en la que junto al importe de cada uno, se anota el valor de la “categoría” equivalente a ese importe, esta vez, redondeada con una cifra decimal. Este cálculo partiendo del importe responde obviamente a la expresión: “ cat = log(Importe) / log 1,1220185 ”

Si hubiera que definir las características intrínsecas de este sistema de una forma general, habría que decir que se trata de un modelo de tipo discontinuo o “discreto” hablando en términos matemáticos, y que esa “discontinuidad” se debe no solo a la aplicación de los precios a través de una escala logarítmica, sino también por el hecho de establecer una lista de componentes “cerrada” reducida solo a los más significativos, que a su vez son “valorados” con la holgura suficiente para compensar aquellos otros que no se incluyen, ya sea por estar muy vinculados con los principales o por tener una incidencia poco significativa en el conjunto del presupuesto.

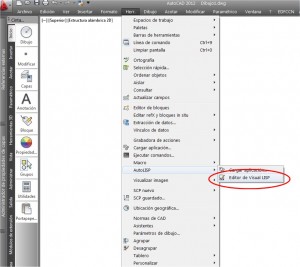

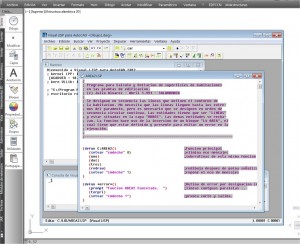

En los párrafos anteriores, se incluye un enlace que permite “descargar” un archivo de hoja de cálculo en el que se desarrolla el sistema comentado. El uso de las hojas es elemental, y basta con “anotar”, los valores oportunos, comenzando por los datos de cabecera, y luego en la columna de la medición, los valores correspondientes, solo en la casilla del componente que se pretende valorar, dejando las demás en blanco. Una vez anotado cada valor, inmediatamente aparecen los resultados en las casillas de los importes. Además de la medición y los datos anotados en las casillas con fondo gris, se pueden modificar las “categorías” escribiendo directamente, aunque en este caso la conveniencia de bloquear los datos iniciales o no, podría depender del uso que se quiera hacer, ya sea como control o comparación de otros resultados, o bien como avance u orientación sobre las magnitudes aproximadas de un futuro proyecto.

Con el fin de facilitar y flexibilizar el uso de la hoja, siempre se muestra en la columna de la izquierda el valor unitario del importe que corresponde a cada componente. La hoja se facilita “protegida” con todas las casillas bloqueadas excepto las que deben recibir los datos, con el fin de evitar la pérdida accidental por sobre-escritura, pero tampoco se establece ninguna contraseña, por lo que la hoja puede ser abierta desde el menú de herramientas. También se “hacen constar” en la cabecera los datos del titular de su “propiedad intelectual”, y la especificación de la licencia “Creative Commons” que regula el uso de la misma en la modalidad de “citar al autor”, permitir solamente “usos NO comerciales”, y la obligación de “publicar en las mismas condiciones” cualquier nuevo desarrollo basado en este.

El último día se publicaba un título homólogo sobre el tema del “rendimiento”. En aquella ocasión se hacían algunas consideraciones sobre rendimiento en el consumo de combustible para las instalaciones de calefacción, justificando la ventaja de disponer dos calderas combinadas, para permitir una respuesta mejor modulada, en unas condiciones de demanda variable, para un sistema de combustión del tipo “todo o nada”.

El último día se publicaba un título homólogo sobre el tema del “rendimiento”. En aquella ocasión se hacían algunas consideraciones sobre rendimiento en el consumo de combustible para las instalaciones de calefacción, justificando la ventaja de disponer dos calderas combinadas, para permitir una respuesta mejor modulada, en unas condiciones de demanda variable, para un sistema de combustión del tipo “todo o nada”. Naturalmente otra de las condiciones básicas cuando se proyecta un avión de pasaje, es que el consumo de combustible esté razonablemente ajustado por una buena eficiencia, para que los costes de operación de sus futuros clientes, sean competitivos y rentables. Esta consideración sin embargo, es totalmente secundaria en el ámbito de la aviación militar, ya que la operación de los aviones depende de requisitos completamente diferentes de la rentabilidad comercial.

Naturalmente otra de las condiciones básicas cuando se proyecta un avión de pasaje, es que el consumo de combustible esté razonablemente ajustado por una buena eficiencia, para que los costes de operación de sus futuros clientes, sean competitivos y rentables. Esta consideración sin embargo, es totalmente secundaria en el ámbito de la aviación militar, ya que la operación de los aviones depende de requisitos completamente diferentes de la rentabilidad comercial. Lógicamente un motor trabajando normalmente en el entorno del 50% de su potencia teórica tiene una primera ventaja, al reducir los desgastes respecto a uno que opera al 75%, pero además tiene la ventaja adicional de que cada kilogramo de combustible se quema con mejor eficiencia y rendimiento, lo cual supone que al final de cada vuelo el avión con solo dos motores, ha quemado menos kilogramos de combustible que un avión de cuatro motores.

Lógicamente un motor trabajando normalmente en el entorno del 50% de su potencia teórica tiene una primera ventaja, al reducir los desgastes respecto a uno que opera al 75%, pero además tiene la ventaja adicional de que cada kilogramo de combustible se quema con mejor eficiencia y rendimiento, lo cual supone que al final de cada vuelo el avión con solo dos motores, ha quemado menos kilogramos de combustible que un avión de cuatro motores.

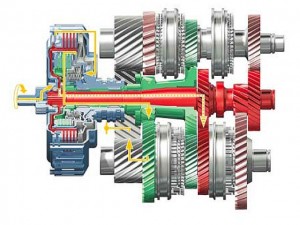

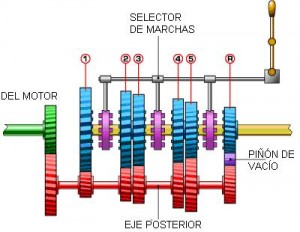

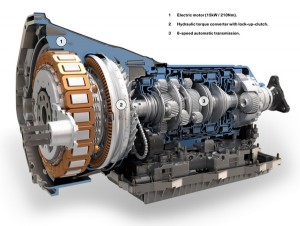

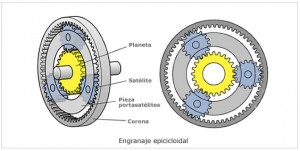

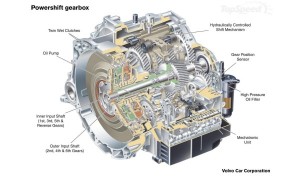

que la mejor forma de ilustrar esas diferencias entre los sistemas, requiere en primer lugar distinguir con claridad las características propias de los dos (manual y automático), que ya ha sido desarrollada en la entrega anterior, para luego comparar las características del nuevo sistema con los anteriores.

que la mejor forma de ilustrar esas diferencias entre los sistemas, requiere en primer lugar distinguir con claridad las características propias de los dos (manual y automático), que ya ha sido desarrollada en la entrega anterior, para luego comparar las características del nuevo sistema con los anteriores.